В современном информационном мире мы все чаще и чаще используем поисковые системы для нахождения нужной информации. Но мало кто задумывается о том, каким образом эти системы находят и индексируют огромное количество веб-страниц. И здесь на сцену выходит поисковый робот, или краулер, который играет важную роль в процессе работы поисковых систем.

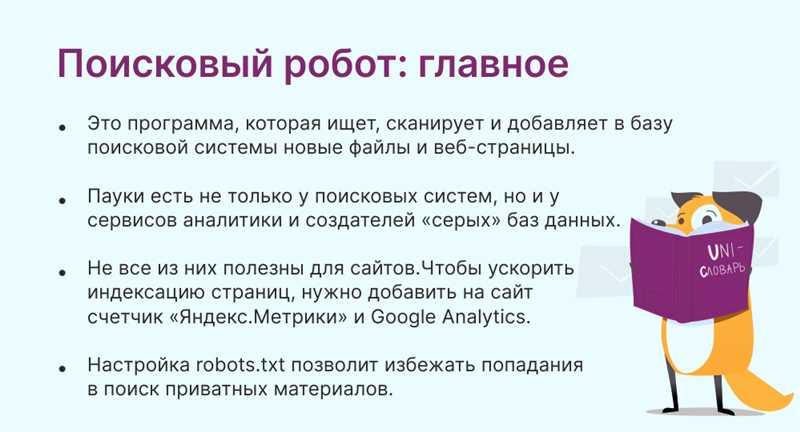

Поисковый робот – это программа, которая автоматически обходит веб-страницы, собирая информацию о контенте и ссылках. Он является основным инструментом, который позволяет поисковым системам индексировать и классифицировать веб-страницы. Поисковый робот часто называют также веб-пауком или краулером.

Краулер начинает свою работу с изучения небольшого набора начальных адресов, таких как главная страница поисковика или популярные новостные сайты. После этого он переходит по ссылкам на другие страницы, пока не обойдет все доступные веб-ресурсы. В процессе обхода краулер анализирует содержимое страниц, сохраняет информацию о них в базе данных поисковой системы и следует дальнейшим ссылкам.

Что такое поисковый робот?

Поисковый робот выполняет такие функции, как поиск новых веб-страниц, обновление уже проиндексированных страниц, сбор ссылок на другие страницы и сбор информации о содержимом этих страниц. Краулеры работают по заданному алгоритму, который указывает, какие страницы следует сканировать, а какие — нет.

Поисковые роботы играют важную роль в работе поисковых систем, таких как Google, Bing и Яндекс. Эти роботы помогают создать индекс, который позволяет пользователям найти нужную информацию в Интернете. Без поисковых роботов было бы практически невозможно найти нужную информацию среди миллиардов страниц, существующих в сети.

Как работает краулер?

Для своей работы краулер использует алгоритмы, которые позволяют ему определить, какие страницы нужно посетить, какие ссылки следует следовать, а какие игнорировать. Кроме того, краулер учитывает такие факторы, как частота обновления страницы, ее релевантность и авторитетность.

- Краулер начинает свою работу с определенной отправной точки, которую называют «seed URL».

- Затем он посещает страницу по этому URL и загружает ее содержимое.

- Краулер анализирует найденные на странице ссылки и добавляет их в свою очередь на посещение.

Во время работы краулер накапливает множество ссылок, формирующих так называемый «граф ссылок». Каждая страница является узлом в этом графе, а ссылки — ребрами, соединяющими эти узлы. Таким образом, краулер продолжает свое путешествие по вебу, посещая все новые и новые страницы и добавляя их в свой индекс.

Функции, выполняемые поисковым роботом

1. Краулинг и индексация

Краулинг, или сканирование, представляет собой процесс, в котором робот посещает веб-страницы по ссылкам и собирает информацию с каждой из них. Робот обходит все доступные ссылки на сайте и проходит по всем страницам, индексируя их содержание. Он анализирует текст, изображения, видео и другие элементы страницы, а также извлекает ссылки для посещения других страниц.

Индексация – это процесс создания поисковыми роботами базы данных, которая содержит информацию о веб-страницах. Робот собирает данные со страниц, а затем добавляет их в свой индекс. Это позволяет поисковой системе эффективно находить и отображать результаты поиска пользователю по запросам.

2. Определение релевантности

3. Анализ структуры сайта

Поисковые роботы анализируют структуру сайта, чтобы понять его иерархию и связи между страницами. Они обращают внимание на ссылки, навигацию и другие элементы, которые помогают им определить важность и ценность каждой страницы. Этот анализ помогает роботам более эффективно индексировать и ранжировать страницы в своих базах данных.

Таким образом, поисковые роботы играют важную роль в работе поисковых систем, обеспечивая сбор и обработку информации с веб-страниц. Они выполняют функции краулинга и индексации, определения релевантности и анализа структуры сайтов. Благодаря этим функциям роботы помогают пользователю находить наиболее релевантные результаты поиска.

Наши партнеры: