Google BERT (Bidirectional Encoder Representations from Transformers) — это нейронная сеть нового поколения, представленная компанией Google в 2018 году. Этот алгоритм используется для обработки естественного языка и понимания запросов пользователей в поисковой системе. BERT стал значительным прорывом в области понимания сложных и разнообразных запросов, так как он учитывает контекст и связи между словами, что позволяет ему точнее интерпретировать смысл запроса.

BERT работает с использованием технологии transformer – модели, которая помогает обрабатывать последовательности данных, сохраняя контекст при обработке каждого отдельного слова в тексте. Такой подход позволяет BERT улавливать смысл и контекст текста, что делает его более эффективным в понимании сложных запросов и поиске связей между словами.

Что такое BERT?

Основная идея BERT заключается в том, что для понимания значения слов и фразы необходимо учитывать контекст, в котором они используются. BERT способен улавливать и учитывать этот контекст, что позволяет ему эффективно выполнить различные задачи, связанные с обработкой текстов.

Как работает BERT?

- BERT базируется на архитектуре Transformer, которая позволяет модели обрабатывать текст входящих данных без упрощения их контекста;

- Обучение BERT осуществляется на больших корпусах текстов, таких как Википедия, чтобы обеспечить модели широкий контекст для понимания;

- Обучение BERT выполняется на задачах, связанных с языком, таких как заполнение пропусков, вопросно-ответные пары, задачи классификации и др.;

- Модель BERT способна генерировать представления для каждого слова, учитывая его контекст и отношения с другими словами в предложении;

- Архитектура BERT позволяет эффективно решать задачи NLP, включая поиск ответов на вопросы, классификацию текстов и составление резюме.

Базовые понятия о BERT

Основное преимущество BERT заключается в том, что она способна эффективно учитывать контекст при обработке текстов, что позволяет модели понимать семантические связи между словами и фразами. BERT использует механизм самообучения, обучаясь на больших объемах неразмеченных текстов, что позволяет модели изучать различные языковые конструкции и синтаксические особенности.

Основные концепции в BERT

Для понимания BERT необходимо ознакомиться с несколькими ключевыми понятиями:

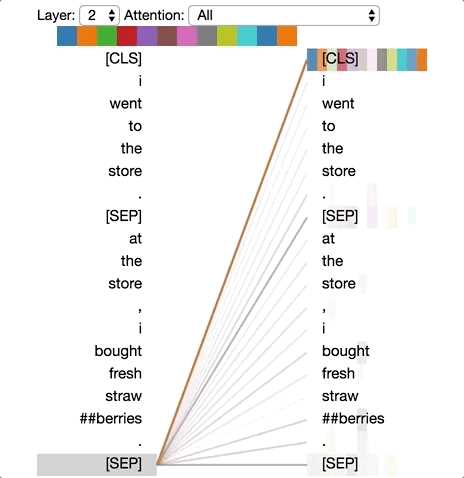

- Трансформер (Transformer) — это модель глубокого обучения, основанная на множестве слоев самообучения. Трансформер применяет механизм внимания (attention) для эффективной обработки и анализа последовательностей данных, таких как тексты.

- Кодировщик (Encoder) — это часть модели BERT, отвечающая за преобразование входного текста в векторное представление. Кодировщики могут быть обучены на большом объеме текстов и использоваться для решения различных задач обработки текста, таких как классификация, семантическая сегментация и генерация текста.

- Маскированное моделирование (Masked Language Modeling) — это один из методов обучения модели BERT. В процессе обучения входные токены случайным образом маскируются, и модель должна предсказать оригинальные значения маскированных токенов. Это позволяет модели учитывать контекст и взаимодействие между токенами при генерации предсказаний.

Как работает BERT?

Для обработки текста BERT использует нейронную сеть с архитектурой трансформера. Обучение модели происходит на больших объемах текста, где каждому слову присваивается векторное представление. В процессе обучения модель учится предсказывать отсутствующие слова в предложении, и таким образом она получает понимание всех слов в контексте предложения.

Трансформеры – это нейросетевые архитектуры, специально разработанные для обработки последовательностей данных, таких как тексты. Они контекстно-зависимые и позволяют учитывать контекст, а также моделируют отношения внутри предложений. Такая архитектура позволяет обрабатывать большие объемы текста и достигать высокой точности в понимании естественного языка.

Преимущества BERT для SEO

Преимущества BERT для SEO являются неоспоримыми:

- Лучшее понимание контекста: благодаря BERT поисковая система Google значительно улучшила способность понимать контекст и смысл запросов пользователя. Это позволяет лучше отвечать на вопросы пользователей и предлагать более релевантные результаты поиска.

- Учет длинных запросов: BERT помогает Google лучше разбираться с длинными запросами и понимать их смысл. Это особенно важно для пользователей, которые задают более специфические или сложные вопросы.

- Учет синонимов и контекстуальных значений: благодаря BERT, поисковая система Google лучше разбирается в значении синонимов и контекстуальных значений в запросах пользователей. Это позволяет более точно подбирать и отображать результаты поиска.

- Лучшая оптимизация контента: с учетом BERT, оптимизация контента на страницах сайта становится более эффективной. Система лучше понимает смысл содержимого и связи между разными элементами страницы.

В итоге, использование BERT в алгоритмах поисковой системы Google позволяет улучшить качество предоставляемых результатов поиска и сделать их более релевантными для пользователей. Это в свою очередь позволяет сайтам и веб-мастерам создавать контент, который будет наиболее полезен и интересен для целевой аудитории. Поэтому, актуальность BERT для SEO неоспорима.

Наши партнеры: